引言

目前数据中心的设计已经在工程行业里形成一个专业领域,针对安装在数据中心内的设备功率密度、可靠性、灵活性等要求,空调系统的实际方式也不尽相同,本文拟就国内某大型企业自用数据中心空调系统的实际案例做一介绍,以供同行参考。

1.工程概况

本工程数据中心大楼为一个4层的钢筋混凝土框架结构建筑,包含主机房、支持区(空调机房、变配电所及UPS间、气瓶间)、冷水站、办公区、装卸货等功能区域。

主机房按照“整体B级,局部高可用”的标准设计,共有10个主机房模块:1、6个模块为常规高密度机房,功率密度可达到2kVA/m2,每个模块的使用面积为500m2,布置在3层和4层;2、3个模块为可兼容非常规高密度机房,功率密度可达到5kVA/m2,每个模块的使用面积为500m2,布置在3层和4层;3、1个模块为高可用机房,功率密度为1kVA/m2,该模块的使用面积为300㎡,布置在1层。

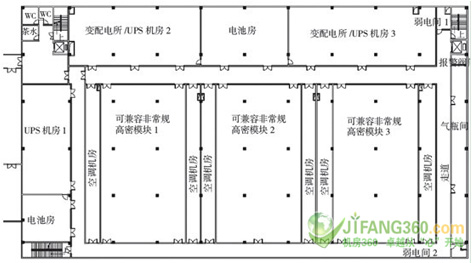

数据中心标准层平面图如图1所示。

图1 标准层平面图

2.数据中心空调系统的特点

- 先进性:模块化配置,满足中远期要求,符合IT发展趋势;

- 可靠性:系统冗余备份,管路多路由,从冷源、管路、末端配置各方面考虑;

- 灵活性:模块化设计,系统具备弹性及可扩充能力;

- 功能性:空间设计以及功能区设置符合服务流程,并能灵活组合;

- 可服务性:易维护、可更新,设施满足监控和运营服务;

- 经济性:节能、绿色环保、自动运行、节能控制与低PUE的绿色数据中心。

3.末端空调系统设计

3.1气流组织

3.1.1常规高密度机房和高可用机房

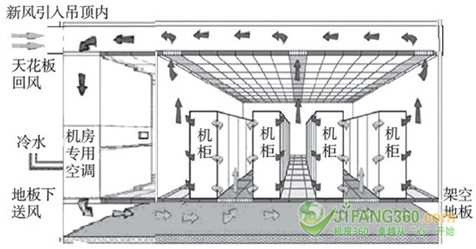

机房空调气流组织,拟采用冷、热通道隔离的方式。机房计算机柜以面对面和背靠背成排方式布置,热通道上方设置透明的软隔断,将冷热通道完全隔离。空调系统采用架空地板下送风、天花吊顶回风的气流组织方式,送风口设置在冷通道的架空地板上,送风口采用孔板分扣600㎜×600㎜,根据送风量设计开孔率,配套调节阀调节每个风口的送风量,回风口设置在热通道的吊顶天花上,风口采用格栅风口600㎜×600㎜。

新风直接从室外经过过滤后引入吊顶回风空间内,与回风混合,平时用于满足工作人员的新风需求和保证机房密封所需要的正压需求。新风处理采用常规吊顶式新风机组。常规高密度机房气流组织图如图2所示。

图2 常规高密度机房气流组织图

3.1.2非常规高密度机房

本计算机楼房的3个非常规高密度机房,计算机设备平均装机用电密度为5kVA,这和到单台机柜的用电量约10kW。该部分空调气流组织拟采用架空地板下送风和机柜局部冷却相结合的方式。地板下送风担负1/3空调负荷,机柜局部冷却装置负担2/3的空调负荷。

空调系统采用架空地板下送风、天花吊顶回风的气流组织方式,送风口设置在冷通道的架空地板上,送风口采用孔板风口600㎜×600㎜,根据送风量设计开孔率,配套调节阀调节每个风口的送风量,回风口设置在热通道的吊顶天花上,风口采用格栅风口600㎜×600㎜。

机柜配套局部冷却系统由制冷主机+制冷末端单元组成。制冷主机仍采用冷水作为冷源,制冷主机与制冷末端单元通过铜管链接,内部充注R134a环保冷媒进行热交换,通过主机控制器控制,保证制冷末端单元蒸发器表面温度高于露点温度,避免蒸发器及冷媒管路表面结露产生冷凝水。非常规高密度机房气流组织图如图3所示。

图3 非常规高密度机房气流组织图

3.2室内空气温度

(1)计算机机房温湿度的确定对于空调系统有较大的影响,也是很关键的设计参数。关于机房的设计温湿度,最新的《电子信息系统机房设计规范》(GB50172-2008)规定,温度为23±1℃,相对湿度为40%~~55%,但是机房区各个区域的温度差异比较大,规范中并没有明确此温度的准确定义点。

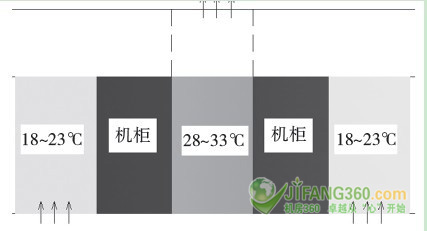

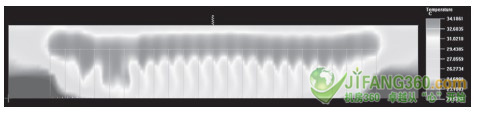

(2)根据美国采暖、制冷与空调工程师学会(ASHRAE标准)的建议,分冷、热通道分别定义温度。这样更科学和更合理的体现机房计算机设备的要求,所以本工程设计的冷通道设计温度为18~23℃,热通道为28~33℃。这样设计会带来如下的优点:1)提高了送风温度,从而提高了换热的效率,即提高冷水机组的能效比,明显节约能源;2)为过渡季节和冬季使用免费冷源冷却提供使用的可能,并增长了可使用的时间;3)为末端精密空调的干况运行提供有利条件,对空气处理过程的节能有较大的好处。冷、热通道温度示意图如图4所示。

图4 冷、热通道温度示意图

3.3空气处理过程

(1)根据计算机房的负荷你,计算机房主要为显热负荷,机房专用空调设计为干工况运行,因为计算机房无工作人员,对于偶尔因少数工作人员进入而带入的湿符合忽略不计。末端空调设计送风温度为18℃,回风设计温度为28℃。

(2)新风处理过程在夏季将室外空气处理到室内空气的温湿度,即23℃和50%,送入空调机房内,冬季仅作过滤处理,不做温湿度的处理直接送入空调机房。新风量的设计采用维持机房正压要求的送风量。

3.4设备设置

机房空调中的空调末端采用机房专用精密空调机组,分别设置于每个机房模块两侧的空调机房内,空调系统均为模块化配置。

常规密度的计算机房模块(6个模块),机房主要采用冷水型机房专用空调机组,每个计算机房模块采用N+1冗余配置,每个模块独立设置1台新风机,同时每个模块内设置1台自动加湿机。

非常规高密度计算机房模块(3个模块),机房同时设置冷水型机房专用空调机组和冷水型功能机。每个计算机房模块采用N+1冗余配置,每个模块独立设置1台新风机,同时每个模块内设置1台自动加湿机。

高可用性的计算机房模块(1个模块),机房主要采用冷水型机房专用空调机组,每个计算机房模块采用N+2冗余配置,每个模块独立设置1台新风机,同时每个模块内设置1台自动加湿机。

4.冷水站设计

4.1系统配置

(1)数据中心的冷源采用10kV高压离心式冷水机组提供,设计参数供水参数7℃,共分为2个完全独立的冷水系统。系统1主要服务6个常规密度模块和1个高可用性模块及其配电辅助用房;系统2主要服务3个高密度的模块及其配电辅助用房。

(2)系统1计算冷负荷为6500kW,采用4台700USRT的水冷离心式冷水机组(3用1备),比设计负荷富裕约10%,考虑了后期可能的容量调整和少量扩容。设置3+1的冗余配置是考虑业主对模块化和高可靠性的设计要求,系统1的1台主机对应2个常规高密度机房模块,系统2的1台主机对应1个非常规高密度机房模块,因此该配置可同时实现模块化、分期实施、高可靠性的需求。

(3)根据参考数据,当每台机柜发热量为14.4kW时,断电后室内温度达到40℃的时间约为1分钟,而系统断电后从柴油发电机的启动到冷水机组正常运行需要较长的时间,因此系统1和系统2的水系统中各设置了一个100m?的储水罐,储备容量为系统满负荷5分钟的循环水量。储水罐与系统采用并联的接入方式,突发停电后,在主机无法及时启动的情况下,替代主机提供冷源。

4.2免费冷源冷却

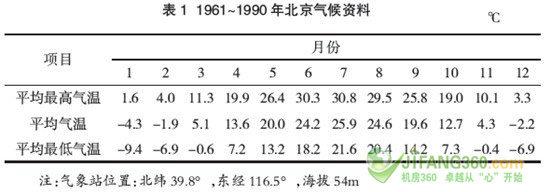

(1)计算机房设备热量是空调系统的主要负荷,在过渡季节和冬季,室外温度已经低于机房温度的情况下,充分利用室外的免费冷空气是计算机房节能的关键。结合本项目的气象条件,设计中采用冬季闭式冷却塔直接供冷的节能方式。计划在室外湿球温度低于7℃的时候开始采用,因项目实施地点靠近北京,采用北京典型年气候条件为设计依据。表1是北京气象统计资料。

(2)经过统计计算,一年中可以免费冷却的时间为12d。根据北京地区气象资料,北京地区连续8小时以上气温湿球温度小于等于7℃的小时数为3120h/a,见表2.冬季气温湿球温度大于7℃时和夏季,空调设备全部运行。

(3)制冷主机和冷却水循环泵将节省30%的运行费用。每台机组的功率为450kW,共计6台,停机时间按每年3120h计算,全年节约800万kWh电。冷却水循环泵的功率为55kW,共6台,停机时间按每年3120h计算,全年节约10万kWh电,节能效果非常明显。

5.绿色数据中心的PUE指标

(1)当前,测量数据中心的能耗指标主要采用PUE——电能使用效率,PUE=数据中心总能耗/IT设备能耗,PUE是一个比率,越接近1表明能效水平越好。

(2)本项目规划IT系统设备供电容量为13800kVA,当功率因素为0.8时,相当于IT系统热负荷为11040kW。如果仍采用旧有的数据中心工艺设计,考虑其它损耗,系统总耗电量将达到惊人的程度。

(3)PUE指标分析:以下我们将结合本项目的实际特点,对数据中心能效比的关键指标——PUE进行初步分析,分析的前提条件如下:1)能源统计范围仅包括高性能计算机房及其办公区;2)高性能计算机房采用冷水系统冷却;3)水冷空调系统的综合能耗比为3.3;4)有功功率因素为0.8.

(4)当机房实际电负荷达到100%设计负荷时,系统的PUE指标为1.56,在免费冷源冷却的运行工作状况下,系统的PUE指标仅为1.30,远低于行业通常水平。

6.常规高密度机房气流CFD模拟

本项目选择了常规高密度的计算机房做了CFD计算机气流模拟。模拟的边界条件根据本公司针对本次机房的空调设计参数,模拟的目的是检验在设计参数下,机房达到稳定状态的情况下,机房温度场的分布状况及气流分布情况,从而修正设计和检验设计的目的,为设计提供直观的参考。本次模拟软件为AIRPANK。

6.1模拟的边界条件

本项目选择了一个典型数据机房约1/3的面积(约168㎡)进行了模拟,机房的宽度和高度均按现有设计,机柜的布置采用冷热通道隔离的方式。计算机设备用电装密度为2kVA/㎡,单机柜的设备用电负荷设定为4kW/rack(按每个机柜占用机房面积2.5㎡)。空调系统的设计参数如下:

送风温度为18℃,回风温度为28℃;

总送风量为79200m?/h;

总回风量为79200m?/h;

机柜散热量4kW,机柜内风扇排风量为120079200m?/h。

6.2模拟结果分析

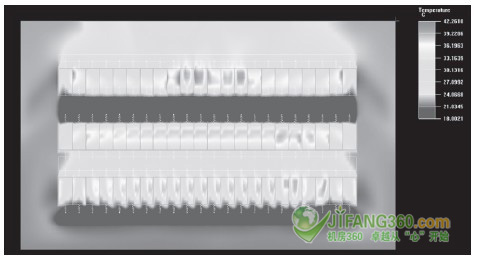

1)地板上0.5m水平温度分布如图5所示。

图5地板上0.5m水平温度分布

从图5可以看出,在0.5m水平面上,冷通道温度约为18~20℃,走道的温度为23℃,热通道约为28~30℃。温度场分布符合冷热通道的设置要求,未出现温度分布不均匀的情况。

2)地板上1.5m水平温度分布如图6所示。

图6 地板上1.5m水平温度分布

从图6可以看出,在1.5m水平面上,冷通道温度约为18~20℃,走道的温度为23℃,热通道约为28~30℃。温度场分布符合冷热通道的设置要求,未出现温度分布不均匀的情况。该平面也是人员通常感官感受的区域。

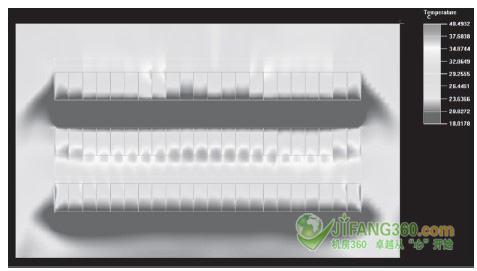

3)地板上2.5m水平面温度分布如图7所示。

图7地板上2.5m水平面温度分布

从图7可以看出,在2.5水平面上,冷通道温度约为18~20℃,走道的温度为23℃,热通道约为28~30℃。温度场分布符合冷热通道的设置要求,该区域是机房机柜的上部区域,冷通道依然保持较好的温度分布,走到温度虽然有点高,但已经是非人员活动的区域。热通道到达温度设定的最大温度。符合设计要求和使用要求。

冷通道垂直温度分布如图8所示。

图8冷通道垂直温度分布

冷通道垂直面上温度在机柜的进风区域保持在18~20℃,而且完全覆盖了机柜的水平和垂直区域,温度分布均匀,没有出现局部的高温,使机柜的进风温度得到保障。

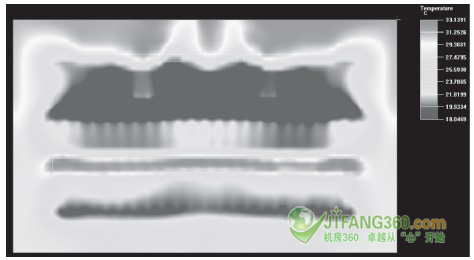

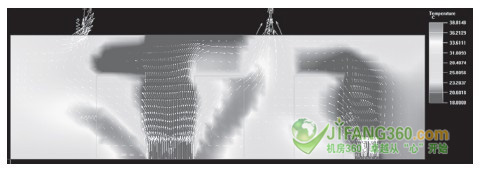

热通道垂直温度分布如图9所示。

图9热通道垂直温度分布

热通道的温度呈现从低到高的分布,温度分布范围为28~33℃,最高温度点出现在机柜上方、回风口下方区域。整体温度分布水平方向相对均匀,垂直呈现由低到高的温度梯度。符合机房对热通道的设置要求。

机房横断面温度分布(房间中部)如图10所示。

图10机房横断面温度分布(房间中部)(说明:左侧的通道是模拟单边的热通道,右侧的通道是模拟单边的冷通道。)

从图中可以看出,冷、热通道完全在不同的温度控制范围。从机房的设计气流组织来看,实际的模拟结果基本验证了设计思路,完全实现冷、热通道的相对隔离。空调低温送风第一时间进入机柜的进风区域,冷却机柜后的热量第一时间进入回风区域。

6.3需要改进的措施

(1)从上述不同的剖面空气温度分布情况,我们可以看出常规的密度的机房采用地板下送风完全可以满足机柜对空调的要求。但是从节能的角度和工作人员的舒适度来考虑,仍需要进行调整。

(2)热通道上方区域采用物理软隔断,更好地保证冷通道和人员的通道不受热空气干扰,同时可以提高末端空调的热交换率。

(3)尽量采用走道单边冷通道的布置方式,避免单边热通道的布置方式,从模拟结果来看,单边热通道的温度比较高,如人员通道走道会不舒服。

结语

本系统在设计时参考了国内外众多大型数据中心建设的经验,设计方案综合考虑了数据中心建设的自身特点,并结合CFD计算机模拟的方式论证了设计的实际可行性。此外由于数据中心的能耗非常惊人,必须采取合理的节能措施,以获得最大的社会效益和经济效益。

我们一直都在努力坚持原创.......请不要一声不吭,就悄悄拿走。

我原创,你原创,我们的内容世界才会更加精彩!

【所有原创内容版权均属TechTarget,欢迎大家转发分享。但未经授权,严禁任何媒体(平面媒体、网络媒体、自媒体等)以及微信公众号复制、转载、摘编或以其他方式进行使用。】

微信公众号

TechTarget

官方微博

TechTarget中国

作者

相关推荐

-

采用冰雪自然制冷 揭秘日本白色数据中心节约成本新举措

日本北海道美呗市白色数据中心(WDC)通过冰雪自然冷却,显著降低数据中心成本。据悉,该白色数据中心项目试验历时五年。

-

关于互联网+时代的数据中心:你得知道这些事

模块化数据中心建设为什么如此流行?什么样的制冷系统能够帮你降低电费清单?互联网+时代下的新一代数据中心如何建?

-

盘点数据中心7月份热门文章

本篇为您盘点数据中心7月份热门文章,迈阿密大学云为先策略为他们带来哪些益处?炎炎夏日,数据中心如何制冷?DC为什么在数据中心发展受限?

-

高密度数据中心如何制冷?

在数据中心中,制冷的重要性不言而喻。尤其是在炎炎夏季,为数据中心降温成为管理员们必须重视的问题。高密度数据中心制冷难在哪?如何为数据中心降温?