盘点全球低PUE数据中心

我们要介绍的是在IT基础架构中扮演重要角色的数据中心。众所周知,云计算时代已经到来,这预示着数据中心面临的挑战也更大,而数据中心的节能冷却系统在其中更是备受人关注。

衡量数据中心能效的一个关键指标就是PUE(能量使用效率),它最初由微软技术专家Christian Belady在2006年提出。目前, PUE已发展成为一个全球性的数据中心能耗标准。PUE的值等于数据中心总能耗与IT设备能耗的比值,比值越小,表示数据中心 的能源利用率越高,该数据中心越符合低碳、节能的标准。国外还提出了与之成倒数关系的DCiE(数据中心基础设施效率)。 PUE和DCiE在2007年2月的时候,被绿色网格组织(Green Grid)定义为衡量数据中心的能效比指标。

PUE与DCiE指标

衡量数据中心在正式介绍数据中心节能冷却系统之前,让我们先来看看全球几大低PUE值数据中心(PUE<1.10)。

1、雅虎“鸡窝”式数据中心(PUE=1.08)

雅虎在纽约洛克波特的数据中心,位于纽约州北部不远的尼亚加拉大瀑布,每幢建筑看上去就像一个巨大的鸡窝,该建筑本身就是一个空气处理程序,整个建筑是为了更好的‘呼吸’,有一个很大的天窗和阻尼器来控制气流。

雅虎“鸡窝”式数据中心

2、Facebook太阳能数据中心(PUE=1.07)

Facebook在俄勒冈州建成了一个大型数据中心,其部分供电由太阳能电池板阵列来供应。该数据中心太阳能电池阵列可以提供100千瓦的电力供应,其主要应用在辅助设施方面,例如低功耗的机械室和办公区域。

Facebook数据中心太阳能板

3、惠普EcoPOD模块化数据中心(PUE=1.05)

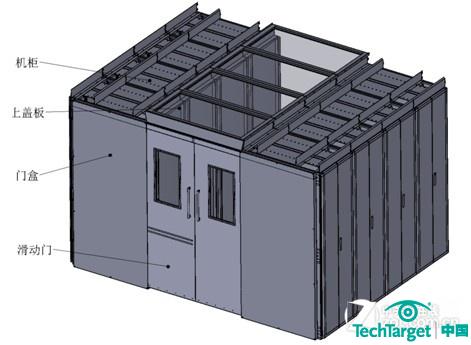

可容纳多达44个工业标准的 IT设备和超过4400台服务器。通过两个冷通道或一个共享的八英尺散热通道来实现,降低了维护难度。Eco POD三大特点:自然进气的惠普自适应冷却技术;全球最快12周交付客户使用;减少75%投资成本

惠普EcoPOD模块化数据中心

4、梅林模块化数据中心(PUE=1.08)

将集装箱数据中心整合,组成了一个大的服务器集群。每个集装箱数据中心都由4个部分组成,可以实现快速部署。另外,梅林数据中心模块80%的材料是可以回收的,大大降低了污染,从而实现低碳化。

梅林模块化数据中心

常见数据中心冷却系统

由于数据中心的发热量很大且要求基本恒温恒湿永远连续运行,因此能适合其使用的空调系统要求可靠性高(一般设计都有冗余备机)、制冷量大、温差小和风量大。下面,我们简要介绍下适合数据中心部署的空调冷却系统。

1、风冷精密空调

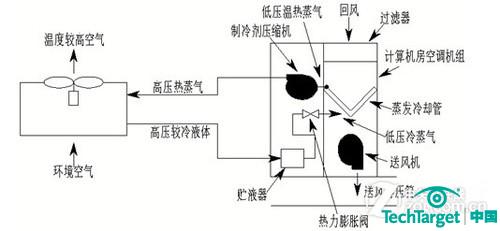

这是数据中心最传统的制冷解决方案,单机制冷能力一般都在50到200KW之间,一个数据机房一般都是安装多台才能满足需要。下面是风冷精密空调的工作原理图。

风冷精密空调工作原理图

风冷精密空调一般采用涡旋压缩机制冷(一般安装在精密空调内),能效比相对比较低,在北京地区一般在1.5到3之间(夏天低,冬天高)。风冷精密空调在大型数据中心中使用存在以下不足:

- 安装困难

- 在夏天室外温度很高时,制冷能力严重下降甚至保护停机

- 对于传统多层电信机房,容易形成严重的热岛效应

- 需要开启加湿除湿功能,消耗大量能源

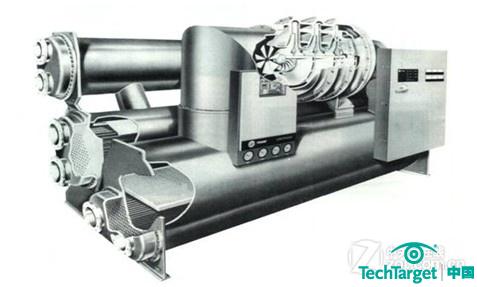

2、离心式水冷空调系统

这是目前新一代大型数据中心的首选方案,其特点是制冷量大并且整个系统的能效比高(一般能效比在3到6之间)。离心式制 冷压缩机的构造和工作原理与离心式鼓风机极为相似。但它的工作原理与活塞式压缩机有根本的区别,它不是利用汽缸容积减小的方式来提高气体的压力,而是依靠动能的变化来提高气体压力。

离心式水冷空调系统

水冷冷冻机组的工作原理

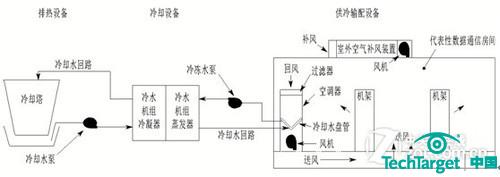

离心式冷冻机组在小负荷时(一般为满负荷的20%以下)容易发生喘振,不能正常运转。因此,在数据中心水冷空调系统的设计中一般先安装一台小型的螺杆式水冷机组或风冷水冷机组作为过渡。大型数据中心的水冷空调系统一般由以下五部分组成,示意图如下。

水冷空调系统示意图

冷却技术和DC选址

免费冷却技术指全部或部分使用自然界的免费冷源进行制冷从而减少压缩机或冷冻机消耗的能量。目前常用的免费冷源主要是冬季或春秋季的室外空气。因此,如果可能的话,数据中心的选址应该在天气比较寒冷或低温时间比较长的地区。在中国,北方地区都是非常适合采用免费制冷技术。

数据中心在环境温度较低的季节,将室外空气经过过滤后直接送入机房作为冷源,也能节省大量能源,称为风冷自然冷却。这种自然冷却方式原理比较简单,成本也比较低,但存在以下不足之处:

- 空气洁净度不易控制

- 空气湿度不易控制

- 温度过低易结露

- 无法实现全年自然冷却

因此,在大型数据中心中对自然环境要求较高,因此不推荐使用风冷自然冷却方式。

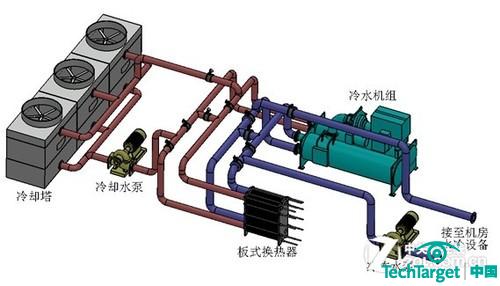

采用水冷空调系统,当室外环境温度较低时,可以关闭制冷机组,采用板式换热器进行换热,称为水冷自然冷却。这样减少了开启冷机的时间,减少大量能源消耗。有专家建议,湿球温度在4℃以下时可以满足完全自然冷却,在湿球温度4到10℃之间可 是实现部分自然冷却。

大型数据中心水冷系统参考示意图

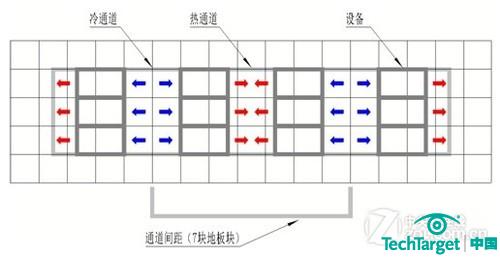

另外,近年来也有采用封闭冷通道进行冷却进而节省能源的做法。地板下送风,天花板上回风,精密空调设置单独安装在设备间,机柜面对面摆放冷热通道隔离并实现冷通道封闭(防止冷气短路),示意图如下。

示意图

冷通道封闭要求做到以下四点:

- 地板安装必须不漏风……

- 冷通道前后和上面要求完全封闭,不能漏风。

- 机柜前部的冷通道必须封闭,没有安装设备的地方必须安装盲板,建议使用免工具盲板。

- 地板下电缆、各种管道和墙的开口处要求严格封闭,不能漏风。

地板下方除了消防管道外,尽可能不要安装任何电缆、线槽或管道,因为这些干扰物会干扰地板下空间的送风气流分布,增加风阻,使不同机柜中设备的冷却性能不均匀。

每个机柜的功率密度低于3KW时建议地板的高度为600mm,功率密度在3到5KW之间地板高度建议800mm,功率密度大于5KW时建议 地板高度为1000mm。

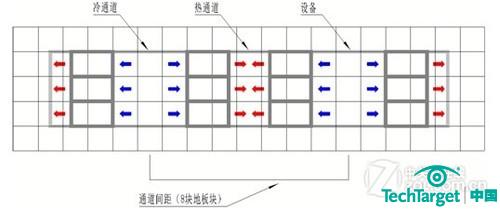

冷热通道和机柜布局

冷热通道和机柜布局

由于防静电地板的尺寸为600mmX600mm,因此对于单个机柜功率密度小于5KW时的最佳布局是7块地板摆两排机柜。而对于高密度机柜,可以根据功率密度和通风地板的通风率决定8块或9块地板摆放两排机柜。

我们一直都在努力坚持原创.......请不要一声不吭,就悄悄拿走。

我原创,你原创,我们的内容世界才会更加精彩!

【所有原创内容版权均属TechTarget,欢迎大家转发分享。但未经授权,严禁任何媒体(平面媒体、网络媒体、自媒体等)以及微信公众号复制、转载、摘编或以其他方式进行使用。】

微信公众号

TechTarget

官方微博

TechTarget中国

作者

相关推荐

-

采用冰雪自然制冷 揭秘日本白色数据中心节约成本新举措

日本北海道美呗市白色数据中心(WDC)通过冰雪自然冷却,显著降低数据中心成本。据悉,该白色数据中心项目试验历时五年。

-

关于互联网+时代的数据中心:你得知道这些事

模块化数据中心建设为什么如此流行?什么样的制冷系统能够帮你降低电费清单?互联网+时代下的新一代数据中心如何建?

-

盘点数据中心7月份热门文章

本篇为您盘点数据中心7月份热门文章,迈阿密大学云为先策略为他们带来哪些益处?炎炎夏日,数据中心如何制冷?DC为什么在数据中心发展受限?

-

高密度数据中心如何制冷?

在数据中心中,制冷的重要性不言而喻。尤其是在炎炎夏季,为数据中心降温成为管理员们必须重视的问题。高密度数据中心制冷难在哪?如何为数据中心降温?