我曾经是HP Virtual Connect Flex-10 10Gb以太网模块的狂热粉丝,但在了解VMware vSphere 5新的增强功能后,我不认为我应该继续在虚拟化环境推荐该模块。如果你必须进行物理服务器的部署的话,将2个板载网卡划分成8个网卡到目前仍是项非常强大的功能。我当然知道有HP也有Virtual Connect FlexFabric 10 Gb/24端口模块,但我的工作环境是iSCSI和NFS的地盘,所以它就不在我的讨论范围。

从vSphere 5.0开始,VMware改进其VMware虚拟分布式交换机(VDS)的功能和整体联网能力,所以现在是收回一些硬件方面投资的时机了。我遇到的拥有装满刀片服务器的机架的大多数人很可能都已经拥有了VMware Enterprise Plus许可证,所以他们已经有权启用 VDS 功能,但是你可能还不知道获得VMware View Premier许可的客户同样也有权使用VDS。在VMware VDS 5中的一些最新功能包括:

- 支持NetFlow v5

- 端口镜像

- 支持LLDP (不限于思科!)

- QoS

- 改进的VM流量优先级处理

- NFS网络I/O控制(NIOC)

最后一个功能就是让我觉得不再需要用到HP Flex-10的原因。网络I/O控制(NIOC)允许你对共享网络接口的流量设置优先级,以动态的方式管制拥塞。我特别喜欢NIOC,因为Flex 10的硬性分配和限制会造成带宽浪费。在VDI的世界中,工作负载变得更加具有突发性。我们可以在使用vMotion时看到这种影响。当我在一个虚拟化环境中执行维护工作时,使用带宽超过2 GBit/s 的连接来迁移用户桌面就很不错了——然而,当你不得不迁移每个刀片服务器上超过50个桌面时,你就只能坐在那里干等一阵子了。当然,这是您的设计,你愿意等是因为你不会希望在白天会因为缺乏带宽而拖累服务性能。

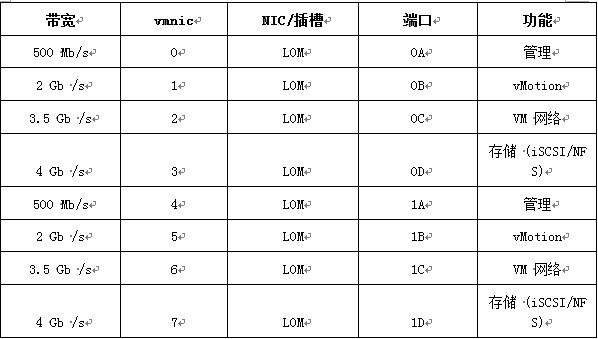

一个典型的Flex 10配置可能会对板载NIC进行如下划分:

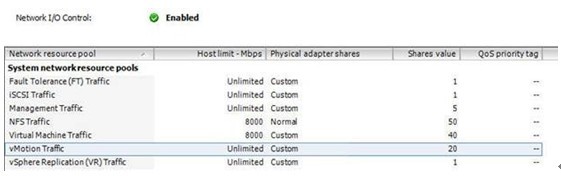

而使用Vmware NIOC进行类似的设置,结果大概就是下面这样:

上面的共享份额加起来应该是:5 + 50 + 40 + 20 = 115

在此示例中,FT, iSCSI和复制不需要纳入统计,因为这里不会用到它们。以上带宽分配比例只有在产生争用时才会被实施。这些共享带宽分配也只在对应的通信流量实际存在的时候才会应用。多个vMotion进程开始动作时,带宽很容易被占满,我认为这就是限制vMotion流量的最佳途径。我觉得 8000Mbps会是一个很合理的限制(已经超过Flex 10配额4倍了)。

管理:5个共享; (5/115) X 10 Gb = 434.78 Mbps

NFS:50个共享; (50/115) X 10 Gb = 4347 Mbps

虚拟机:40个共享; (40/115) X 10 Gb = 3478 Mbps

vMotion:20个共享; (20/115) X 10 Gb = 1739 Mbps

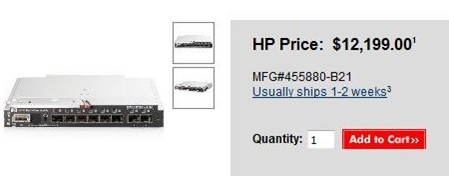

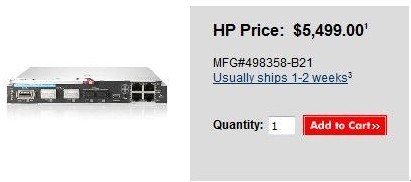

有效带宽的提升,再加上节省的成本,我认为NIOC配合10GB方案值得推广。下面是2011年11月28日的一些列表价格:你会选择哪一个?

Flex-10

HP_6120G XG

Dwayne是BladesMadeSimple.com的最新贡献者,也是IT Blood Pressure (http://itbloodpressure.com/)的专题作家,他提供虚拟桌面技巧,并给出医疗保健行业的IT最佳实践建议。Dwayne的正式工作是:加拿大西部的医疗保健和能源部IT基础设施专家。

我们一直都在努力坚持原创.......请不要一声不吭,就悄悄拿走。

我原创,你原创,我们的内容世界才会更加精彩!

【所有原创内容版权均属TechTarget,欢迎大家转发分享。但未经授权,严禁任何媒体(平面媒体、网络媒体、自媒体等)以及微信公众号复制、转载、摘编或以其他方式进行使用。】

微信公众号

TechTarget

官方微博

TechTarget中国

相关推荐

-

透析Windows Server 2012全新存储功能

Windows Server 2012中包含了数项全新存储功能,有助于帮助用户应对如今的存储挑战。

-

VMware:正式发布vSphere 5 厂商纷纷支持

随着VMworld 2011的召开,用户就可以开始下载VMware最新的vSphere版本。vSphere能支持1TB的RAM和32个虚拟CPU。

-

TechTarget数据中心8月虚拟化重要新闻

尽管客户们纷纷怀疑一体化聚合基础设施套件是否必要,惠普仍然为VMware上市了三种VirtualSystem产品,将惠普的服务器、存储、网络和VMware虚拟化融为一体。

-

VMware vSphere 5:向上扩展还是向外扩展?

在x86中,对于向上扩展还是向外扩展这一争论又有了新的话题,那就是VMware vSphere 5的授权方式。